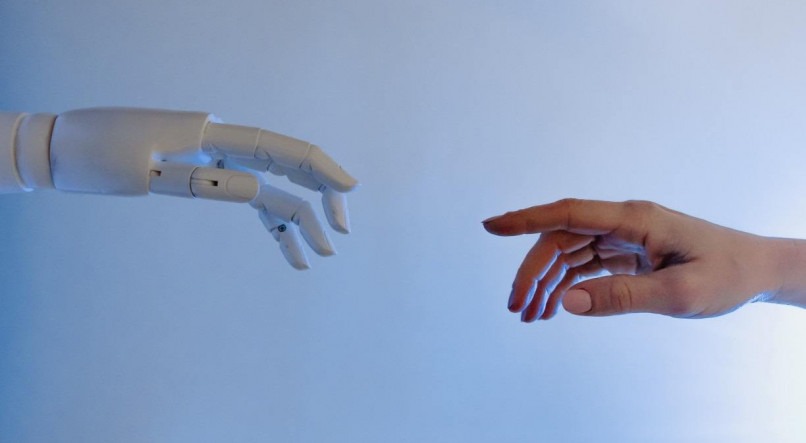

Imagina poder simular uma conversa com um programa de computador que tenta imitar um diálogo tão real quanto a de um ser humano? Esse é o papel do chatbot, programa de computador que replica um diálogo de forma tão real que a impressão que o usuário tem é de estar conversando com outra pessoa, e não com um programa.

Agora pense poder conversar com uma pessoa que já faleceu? Esse foi o dilema vivido pelo desenvolvedor Jason Rohrer, que recebeu uma ordem da empresa OpenAI, instituição responsável pelo robô, para desativar o chatbot que criou, uma vez que havia perdido a permissão para a utilização da tecnologia de inteligência artificial (IA).

O motivo? Um rapaz criou um robô de conversas baseado no programa de Jason, adaptando-o para reproduzir conversas com a noiva falecida.

Como funcionava essa tecnologia?

A partir de julho deste ano, o chatbot, criando por Jason, chamou atenção de diversos usuários. Com isso, ele criou o 'Project December', o que permitia que outras pessoas pudessem treinar as suas próprias versões do programa/robô.

E foi exatamente isso que Joshua Barbeau, 33, fez: treinou a IA para poder simular conversas com sua noiva, falecida em 2012, aos 23 anos, por causa de uma rara doença hepática.

O projeto de Jason foi criado por um software conhecido como GPT-3. Essa tecnologia "sabe como manipular a linguagem humana, gerando texto em inglês fluente em resposta a uma solicitação", explica o jornal San Francisco Chroniele. O GTP-3 é muito mais avançado do que assistentes digitais, como a Siri (da Apple) e a Alexa (da Amazon), uma vez que é capaz de simular, praticamente, qualquer estilo de escrita com o toque de um botão.

Assim que soube das consequências do projeto, a OpenIA mandou o desenvolvedor encerrar a iniciativa ou inserir obstáculos para evitar outros episódios possíveis de "uso indevido". Apesar dos esforços, Jason precisou seguir a condição da empresa. Logo em seguida, a OpenAI iniciou o processo de desligamento remoto da tecnologia.

A situação fez com que todos os robôs construídos tendo como base o algoritmo de texto GPT-3 se tornassem menos inteligentes, convincentes e com bugs que impediam o funcionamento apropriado.